Kilka słów po rządowym hackathonie z perspektywy oceniającego prezentowane projekty

Już po rządowym hackathonie, który w miniony weekend odbywał się w Bibliotece Narodowej w Warszawie. Oto garść refleksji dotyczących ponownego wykorzystania informacji z sektora publicznego. Z jednej strony piszę je z perspektywy komentatora, który od ponad 20 lat przygląda się konfliktom prawnym związanym z obiegiem informacji, ale mniej więcej w połowie drogi, 11 lat temu, uznał, że ów re-use jest niezwykle ważny dla rozwoju demokracji. Pisząc ten komentarz pamiętam też, że jako członek Jury, które przyznać miało nagrody w organizowanym przez Ministerstwo Cyfryzacji konkursie, miałem swój głos i za jego pomocą wpływ na trzy z czterech nagród (czwarta to nagroda specjalna przyznana suwerennie przez PWPW). Teoretycznie więc powinienem się wypowiedzieć przez ten głos, ale przecież mam jeszcze kilka słów komentarza na temat moich "preferencji wyborczych".

Bardzo zdziwiło mnie, że tak wiele zespołów postanowiło przygotować rozwiązania wyszukujące klauzule niedozwolone w regulaminach. I miałem niedosyt, ponieważ samo zidentyfikowanie klauzuli na podstawie bazy UOKiK, nawet przy logice rozmytej i dzięki trickom mającym na celu znajdowanie klauzul "podobnych", nie załatwia problemów grup docelowych, które wskazywali w prezentacjach przedstawiciele zespołów projektujących aplikacje. Albo inaczej: uważam, że warto, by zajmujący się tymi klauzulami pochylili się raz jeszcze nad precyzyjnym określeniem problemu do rozwiązania przez projektowane narzędzie technologiczne. Bo przecież jeśli ktoś nie czyta regulaminów serwisów internetowych, to po co mu narzędzie, które będzie mu wskazywało w tych regulaminach klauzule niedozwolone? A jak już mu wskaże, to co dalej? Co ma zrobić z taką klauzulą ów korzystający z informatycznego narzędzia konsument? Algorytm nie zastąpi człowieka (i nawet nie chodzi o to, że algorytm nie zastąpi prawnika, bo wielu nieprawników, w szczególności zajmujących się ochroną konsumentów, potencjalnie może lepiej się orientować w klauzulach abuzywnych niż niejeden prawnik). Jeśli ktoś nie czyta regulaminów, to nie będzie też chciał znajdować klauzul niedozwolonych. Natomiast podejście "no brain" jako dyrektywa projektowa przy projektowaniu rozwiązań mających na celu "analizę" regulaminów czy analizę prawa, zwłaszcza jeśli rozwiązanie jest kierowane do specyficznej grupy odbiorców, czyli do konsumentów, jest - moim zdaniem - hmm... ryzykowne z perspektywy odpowiedzialności społecznej.

Przy okazji ponownie rozjarzyła się dyskusja na temat algorytmizacji prawa. W opublikowanym właśnie tekście pt. Rządowy hackathon, czyli 30 godzin bez snu Eliza Kruczkowska, z którą wspólnie zasiadałem w Jury, pisze m.in., że popularność aplikacji do szukania kruczków prawnych i niedozwolonych klauzul to "potwierdzenie niewątpliwie rosnącej popularności „smart contracts”, które otwierają fascynującą dyskusję na temat istoty i przyszłości prawa". Tu się jednak nic nie otwiera, bo ta dyskusja toczy się od lat. A w niej m.in. tezy o potrzebie algorytmizacji prawa i o kontraktach zawieranych przez algorytmy (por. m.in. Człowiek potrafi pokonać maszynę na giełdzie (ale sąd tego nie docenił) i O tym, że nie rozumiemy do końca, jak algorytmy grają na giełdzie).

Algorytmizacja prawa nie jest nowym konceptem i sporo na ten temat już napisano. Cóż z tego, że umowy (kontrakty) będą algorytmami, skoro to nie zastąpi zgody stron na treść kontraktu, jak również nie zastąpi rozumienia tego, co jest istotą kontraktu zalgorytmizowanego (a bez rozumienia trudno mówić też o zgodzie na postanowienia kontraktu, czyli o swobodzie kontraktu). Oczywiście rozumiem, bo już trochę w tej dyskusji siedzę, że od czasu do czasu koncepcja algorytmizacji w sferze prawa zyskuje nowych zwolenników. Algorytm nie zastąpi jednak u konsumenta umiejętności rozwiązania kwadratu logicznego, a zwolennicy algorytmizacji prawa często nie zdają sobie sprawy, że system prawny może ulec zmianie, chociaż w danym zakresie nie ulegną zmianie przepisy ten system tworzące. To dlatego, że system prawny posługuje się m.in. klauzulami generalnymi. No, ale cóż. Kolejne ogniska entuzjazmu dla algorytmizacji traktuję jako przejaw procesu edukacji prawno-społecznej. Gorzej by było, gdyby ludzie nie szli w taką uliczkę wcale, a tak może wchodząc w nią zauważą jej ograniczenia. Ogólnie to dobrze, że od czasu do czasu wybucha taki entuzjazm dla "algorytmizacji prawa". Dzięki temu więcej ludzi dowiaduje się, jak w istocie prawo działa.

W dyskusji w serwisie Facebook Lech Wilczyński skomentował powyższe stwierdzenie słowami:

smart contracts nie obejmują wszystkich zagadnień prawa, ale te które mogą być wykonane w sposób cyfrowy. Dla działania smart contracts wymagane są takie elementy jak, zdecentralizowana cyfrowa waluta, zdecentralizowane środowisko obliczeniowe i w niektórych przypadkach tzw. wyrocznie. Przykłady najprostszych to np. spadek, kontrakt małżeński, ale również autonomiczne organizacje. Inteligentne kontrakty wykonują się bez udziału i decyzji ludzi i działanie jest bezwzględne.

Odpowiedziałem, że mamy przykład problemu. Ja pisałem o algorytmizacji prawa, komentator o smart contracts (ja komentowałem to, co Eliza napisała w nawiasie facebookowego komentarza, a mój adwersarz to, co poprzedzało nawias). A wydawałoby się, że powinniśmy się rozumieć jako ludzie. To ludzie programują algorytmy. Również te, które mają "zastępować" ludzi przy stosowaniu prawa. Nawiasem mówiąc - "bezwzględne" stosowanie algorytmu w relacjach społecznych jest - jak uważam - nie do zaakceptowania z perspektywy zasad konstytucyjnych demokratycznych państw prawa. Już samo automatyczne stosowanie takich rozwiązań nie da się pogodzić z koncepcją wad oświadczeń woli, gdzie wśród nich jest m.in. brak świadomości lub swobody.

Uważam jednocześnie, że narzędzia informatyczne mogą się przydać w analizie prawa. Koncepcja zaawansowanej analizy tekstu leżała u podstaw prób tworzenia systemu SAOS - System Analiz Orzeczeń Sądowych, który projektowaliśmy i przygotowywaliśmy w ramach konsorcjum, w którym liderem było Interdyscyplinarne Centrum Modelowania Matematycznego i Komputerowego UW, a który - w pierwszym podejściu do jego projektowania - miał m.in. znajdować rozbieżności linii orzeczniczej przy podobnych stanach faktycznych. Jednak nie był narzędziem kierowanym do konsumentów "nieprofesjonalnych", a raczej narzędziem wsparcia profesjonalistów mających coś zrobić z takimi wynikami. Komentując powyżej odniosłem się jakby do wektora potrzeb grupy docelowej. To właśnie narzędzia mające wspierać bezrefleksyjnych konsumentów w jeszcze większym braku refleksji uważam za - szukam ostrożnych słów - działania nierozwiązujące, a pogłębiające problem.

W czasie Auli Polskiej w dniu 22 października 2015 opowiadałem o swoich doświadczeniach przy tworzeniu systemu analiz orzeczeń sądowych.

Ministerstwo Cyfryzacji przygotowując Hackathon zderzyło się, być może po raz pierwszy, z problemami użytkowników, którzy usiłują pozyskiwać i wykorzystywać "uwolnione" dane publiczne. Ja po swoich doświadczeniach z projektowaniem i tworzeniem SAOS-a, ale i po wcześniejszych projektach związanych z re-use, sformułowałem postulaty dotyczące konieczności stworzenia dwóch procedur, które nie są dziś obecne w programach otwierania danych.

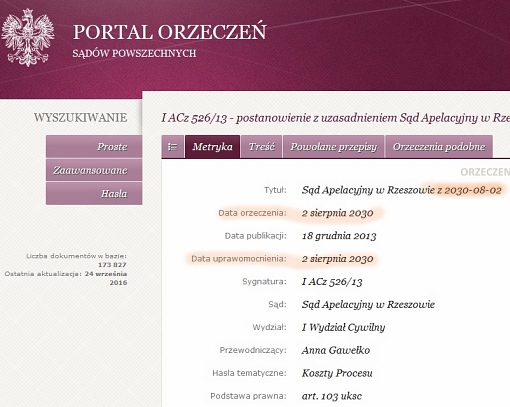

Pierwsza dotyczy zgłaszania błędu dostrzeżonego w danych lub sposobie ich udostępniania (por. "Zgłoś błąd" - słaba jakość danych publicznych). Dziś trzeba używać instytucji takich jak wniosek, skarga czy petycja, by ktoś - w takim lub innym stopniu poczuł się odpowiedzialny za informacje publiczne (pomijam tu celowo takie narzędzia, jak uruchomienie opinii publicznej przez prasę, publicystykę, albo kampanie społeczne organizacji pozarządowych). A Hackathon rządowy to przecież dobry pretekst, by przypomnieć, że po latach monitów nie udało się poprawić daty opublikowanego w ramach Portalu Orzeczeń Sądów Powszechnych orzeczenia "z 2 sierpnia 2030 roku". A przecież jakość danych publicznych to też narzędzie budowania zaufania obywateli do państwa i taka norma postępowania wynika z zasady demokratycznego państwa prawnego.

Zrzut ekranu orzeczenia Sąd Apelacyjny w Rzeszowie "z 2030-08-02", sygna. I ACz 526/13.

Korzystając z pretekstu Hackathonu oraz wiedząc, że Ministerstwo Sprawiedliwości "obserwuje" mnie w serwisie Twitter, po raz kolejny zasygnalizowałem problem jakości danych publikowanych przez sądy. Być może w ramach poprawy funkcjonowania wymiaru sprawiedliwości warto silniej postawić na standardową (w rozumieniu standardów struktury dokumentu elektronicznego i standardów nienadmiernej anonimizacji: por. Nadmierna anonimizacja orzeczeń prowokuje wnioski o dostęp do informacji publicznej), elektroniczną publikację orzeczeń. I dodałem, że Portal Orzeczeń Sądów Powszechnych MS ma API, nie ma go NSA, SN, TK. Natomiast MS nie ma procedury uruchamiającej poprawę błędów.

Jeśli chodzi o drugą procedurę, to chodzi o procedurę informowania w przypadku modyfikowania API. Zwykle opowiadając o niej przywołuję historię Naczelnego Sądu Administracyjnego, który publikując orzeczenia linkował do stron Sejmu RP, a konkretnie do Internetowego Systemu Informacji Prawnej (wówczas ISIP). Ale kiedy Sejm zmienił sposób publikacji (zastąpił subdomenę isip.sejm.gov.pl na isap.sejm.gov.pl) - serwis NSA "wyleciał w kosmos". Jak to zrobić lepiej? Powinny powstać procedury pozwalające każdemu zainteresowanemu zapisać się na listę dystrybucyjną komunikatów technicznych dotyczących danego źródła danych. Odpowiedzialny za zmiany powinien z wyprzedzeniem informować o planowanych modyfikacjach, informować o tym, czego zmiany będą dotyczyły, a to pozwoli odbiorcom informacji na przygotowanie się do ich wprowadzenia. To tylko zmiana przełącznika w świadomości publikujących dane publiczne, co sprowadza się do świadomości, że nie są sami, że publikują dla kogoś i tego kogoś trzeba uwzględnić w swoich działaniach.

I jeszcze jeden komentarz związany z moimi motywacjami w trakcie oceniania projektów prezentowanych na Hackathonie. Otóż chodzi o narzędzia wsparcia analityki publicznej.

Oczywiste jest dla mnie, że same dane (pamiętając o odłożonym chwilowo na bok problemie ich "jakości") nie wystarczą, by na ich podstawie analizować zjawiska społeczno-gospodarcze. Potrzebne są jeszcze właściwie przygotowane modele, a więc coś, co wspierałoby proces uchwycenia współzależności zjawisk i interpretacji takiej współzależności. Gdyby przyjąć za wzorzec odbiorcy abstrakcyjnego "przeciętnego obywatela" (to oczywiście nieprecyzyjne określenie i wiele tomów zajęłyby spory o to, jak takiego "przeciętniaka" zdefiniować), to taki "przeciętny obywatel" nie będzie wiedział, jakie są zależności między wysokością podatków, a produktem krajowym brutto per capita, nie będzie potrafił powiedzieć, czy ten ostatni parametr jest czy nie jest istotny dla niego, a określenie "ceteris paribus" uzna za inwokację jakiegoś szpetnego przekleństwa.

Dane (dobrej jakości), a zwłaszcza dane dotyczące finansów publicznych (finanse publiczne to klucz do demokracji, bo to one świadczą o rzeczywistych sposobach redystrybucji dóbr w systemie politycznym), są potrzebne. Wyniki badań naukowych z dziedziny socjologii i ekonomii, które pozwalają coraz bardziej precyzyjnie określać zależności między zjawiskami, są równie potrzebne.

Gdy zaczynamy rozmawiać o "dowodach" i modelowaniu - nie jest przedmiotem gry politycznej przekonywanie wyborców, że inflacja rośnie lub maleje, bo to wynika z mierzonych i publikowanych danych. A jeśli są dane i każdy może ich "dotknąć", to teraz pojawia się kwestia ich interpretacji, a także interpretacji postulatów związanych z działaniami, które trzeba podjąć by uzyskać jakiś, oczekiwany efekt w systemie społeczno-gospodarczym. Bo jeśli inflacja rośnie lub maleje to dobrze, czy źle, a jeśli dobrze lub źle, to dla kogo dobrze, a dla kogo nie? Czy jeśli podejmiemy takie lub inne działania, to uzyskamy efekt zatrzymania inflacji, czy wręcz przeciwnie? Kolejny etap, to właśnie owe, wynikające z nauki, a więc powstające w wyniku procesu krytycznej analizy, modele zależności. Nie wystarczy zmierzyć patykiem promień koła, bo trzeba wymyślić formułę "πr2" i jeszcze zgodzić się, że jest wystarczająco dobra, by zmierzyć tego koła powierzchnię.

Chociaż niektórzy koledzy w Jury widzieli w projekcie Media 3.0. jedynie coś na kształt gry wykorzystującej wybrane zbiory danych publicznych jako "środowisko gry", to ja uważam, że takie zabawy "suwakami", jeśli tylko udałoby się je wesprzeć ekonometrią i - co istotne - wyjaśniać w takim narzędziu metodykę przyjętych założeń ekonometrycznych, to kierunek, dzięki któremu (z czasem) pełniej będziemy potrafili tworzyć przepisy "w oparciu o dowody", rzetelniej będziemy potrafili tworzyć oceny skutków regulacji (zwane też ocenami wpływu). Dlatego w czasie obrad Jury gardłowałem za propozycją Media 3.0., chociaż mam świadomość, że w 24 godziny nie napisze się narzędzia analitycznego, które dałoby się rzetelnie stosować w poważnych analizach.

Podtrzymuję przy tym postulat, który formułowałem kilka lat temu, gdy wskazywałem przykłady chorwackiego Proračunskiego kalkulatora i amerykańskiego Stabilize the Debt: An Online Exercise in Hard Choices. Tak. Nadal przydałby się w Polsce dostępny dla wszystkich obywateli wraz z informacją o przyjętych założeniach do jego powstania "kalkulator/symulator budżetu państwa", by wspierać demokratycznie rozumianą dyskusję o finansach publicznych opartych na dowodach (por. Przydałby się kalkulator/symulator budżetu państwa (finanse publiczne oparte na dowodach)).

Realizacja postulatu formułowania prawa w oparciu o dowody, a szerzej - realizacja postulatu formułowania polityk publicznych w oparciu o dowody, zderzyć się musi z koncepcją polityki rozumianej jako proces zdobycia i utrzymania władzy. A przynajmniej oznacza, że dyskurs polityczny zaczyna mieć inny charakter i przy równym dostępie do dowodów ciężar polityki przesuwa się na proces interpretacji dowodów w interesie takiej lub innej grupy społecznej, którą biorący udział w wyścigu wyborczym próbują zagospodarować. Dlatego wprowadzenie takiego postulatu w życie jest hmm... trudne.

I hackathon oraz ocena projektów tam prezentowanych może być tu dobrym przykładem powyższej tezy. Warunkiem dopuszczenia do konkursu było opublikowanie przygotowanych projektów w serwisie GitHub. Wszyscy uczestnicy prezentacji, w tym członkowie Jury, mieli możliwość zapoznania się z nimi w równym stopniu. Mieliśmy kryteria oceny i dostęp do "dowodów", ale w Jury odbyła się burzliwa dyskusja na temat tego, który projekt powinien zostać nagrodzony i dlaczego akurat ten lub inny. I można filozoficznie stwierdzić, że kto wybiera arbitra, ten ma wpływ na wyrok, albo rzucić sentencją "pokaż mi sędziego, a powiem ci, kto wygra".

Ja obecnie pracuję w Ministerstwie Rozwoju jako ekspert w Departamencie Doskonalenia Regulacji Gospodarczych (a za chwilę przeniosę się do Departamentu Oceny Ryzyka Regulacyjnego). Ale wcześniej silnie angażowałem się we wsparcie działań rządu projektującego i realizującego program "Lepsze Regulacje" (por. Rząd przyjął program "Lepsze regulacje 2015") i z perspektywy pozarządowej analizowałem tworzenie przez rząd ocen skutków regulacji (por. Tworzenie i konsultowanie rządowych projektów ustaw - publikujemy wyniki monitoringu. Czy zatem powinny dziwić moje sympatie do takich lub innych projektów otrzymanych do oceny?

A kto wygrał? Wygrał projekt, który jest narzędziem wsparcia procesu obsługi obywatela w urzędzie. Drugie miejsce zyskał projekt, który wspierać ma konsumentów leków refundowanych w procesie wyboru tańszych zamienników (to również mój faworyt). Trzecie miejsce zaś zyskał projekt wykorzystujący opublikowane przez Wrocław dane budżetu partycypacyjnego.

Informacje na temat hackathonu znaleźć można na stronie poświęconej przedsięwzięciu. Jeśli chodzi o nagrody - za zajęcie I miejsca Jury miało przyznać nagrodę w wysokości 18 tys. złotych, za drugie miejsce 13 tysięcy, a za zajęcie trzeciego miejsca - 9,5 tysiąca. PWPW przyznawała swoje wyróżnienie i 10 tysięcy złotych. Ocenialiśmy projekty wedle założonych kryteriów, a wśród nich: sposób wykorzystania w projekcie danych publicznych, odpowiedzenie na potrzeby użytkowników, dobór rozwiązań technologicznych, jakość prototypu, potencjał wdrożenia i samą prezentację projektu. Ostatecznie w konkursie prezentowało się 16 zespołów.

PS

W kuluarach Hackathonu sugerowałem, by w serwisie danepubliczne.gov.pl opublikowano wektorowy herb Rzeczypospolitej Polskiej.

- Login to post comments

Piotr VaGla Waglowski

Piotr VaGla Waglowski - prawnik, publicysta i webmaster, autor serwisu VaGla.pl Prawo i Internet. Ukończył Aplikację Legislacyjną prowadzoną przez Rządowe Centrum Legislacji. Radca ministra w Departamencie Oceny Ryzyka Regulacyjnego a następnie w Departamencie Doskonalenia Regulacji Gospodarczych Ministerstwa Rozwoju. Felietonista miesięcznika "IT w Administracji" (wcześniej również felietonista miesięcznika "Gazeta Bankowa" i tygodnika "Wprost"). Uczestniczył w pracach Obywatelskiego Forum Legislacji, działającego przy Fundacji im. Stefana Batorego w ramach programu Odpowiedzialne Państwo. W 1995 założył pierwszą w internecie listę dyskusyjną na temat prawa w języku polskim, Członek Założyciel Internet Society Poland, pełnił funkcję Członka Zarządu ISOC Polska i Członka Rady Polskiej Izby Informatyki i Telekomunikacji. Był również członkiem Rady ds Cyfryzacji przy Ministrze Cyfryzacji i członkiem Rady Informatyzacji przy MSWiA, członkiem Zespołu ds. otwartych danych i zasobów przy Komitecie Rady Ministrów do spraw Cyfryzacji oraz Doradcą społecznym Prezesa Urzędu Komunikacji Elektronicznej ds. funkcjonowania rynku mediów w szczególności w zakresie neutralności sieci. W latach 2009-2014 Zastępca Przewodniczącego Rady Fundacji Nowoczesna Polska, w tym czasie był również Członkiem Rady Programowej Fundacji Panoptykon. Więcej >>

Czy te

Czy te aplikacje/prezentacje/pomysły będą dostępne w internecie?

Tak, zarówno opis

Tak, zarówno opis pomysłów, jak i linki do GitHubów będziemy publikować na stronkę www.hackathon.gov.pl

"Bo przecież jeśli ktoś

"Bo przecież jeśli ktoś nie czyta regulaminów serwisów internetowych, to po co mu narzędzie, które będzie mu wskazywało w tych regulaminach klauzule niedozwolone?"

"Bo przecież jeśli się ktoś nie zna na bezpieczeństwie oprogramowania, to po co mu narzędzie, które będzie mu wskazywało wirusy?"

Pozdrawiam serdecznie.

No właśnie - po co?

No właśnie - po co? Narzędzie do wskazywania wirusów, jeśli tylko to miałoby robić, byłoby bez sensu. Dlatego narzędzia takie zwykle jeszcze robią coś dodatkowego. Na przykład blokują, usuwają, przesuwają do kwarantanny, informują centra o nowych sygnaturach. Dlatego, chociaż doceniam próbę polemiki, ale uznaję, że nietrafionej użyto w niej analogii.

--

[VaGla] Vigilant Android Generated for Logical Assassination

Pierwsze antywirusy nie

Pierwsze antywirusy nie były przecież tak zaawansowane. Przypominały raczej szczepionki - lub były innymi wirusami stworzonymi tylko do walki z tymi pierwszymi.

Zatem pierwsi użytkownicy tych "antywirusów" mieli do czynienia dokładnie z takimi problemami.

Tutaj masz "sito" dla przeciętnego Kowalskiego - może to być o tyle przydatne, że będzie kazało jednak się przyjrzeć takiej umowie - lub dokładniej ją poczytać. Pewnie skuteczność takiego systemu będzie dyskusyjna ale zawsze to jest wcześniejsze wykrywanie i część z ludzi na tym skorzysta.

Zresztą od czegoś trzeba zacząć - nie sądzę, że można od razu tworzyć bardzo zaawansowane systemy. Dlatego nie zniechęcał bym tych młodych ludzi słowami "Po co?".

Pytanie o cel

Pytaniem jest czy:

- Chcemy mieć systemy które mapują rzeczywistość i pozwalają zakdować zależności, które autorzy prawa chcieli umieścić w kodzie prawa. I na tej podstawie mieć obraz "rzeczywistości".

- Mają to być systemy - które wyłapują nowe nieznane zależności. Próbują identyfikować nowe drogi interpretacji - które mogą z kolei być nieprecyzyjne lub nielegalne. Generalnie mają badać spójność reguł opisanych prawem - tego typu systemy widzę bardziej jako CAD prawa.

- Mają to być filtry - które tylko częściowo wyłapują specyficzne przypadki (np jak klauzule niedozwolone etc). I pozwalają odsiać i przeczesać typowe "błędy" konstrukcyjne.

Jako prawnik posługujesz się z pewnością, różnymi narzędziami

formuła hackathonów

Pozwolę sobie tylko skrytykować samą formułę hackathonu. Uważam że gdyby na wykonanie tych projektów było więcej czasu i nie wymagano udziału osobistego, zainteresowanych byłoby wielokrotnie więcej osób. Po co jechać pół Polski i bite 30 godzin klecić naprędce jakąś apkę na niewygodnym laptopie, nie śpiąc i nie dojadając. Po co tak utrudniać? Przecież można by to zorganizować podobnie do tego jak działają np. contesty na topcoder.com, gdzie też projektuje się aplikacje, ale ma się na to więcej czasu (np. z 2 tygodnie) i można nad nimi spokojnie popracować w domu. Dla mnie hackathon to absurd i mimo tego, że mam wolny czas, który mógłbym poświęcić na tego typu rzeczy, to na pewno nie będę jechał do Warszawy, żeby z jakimiś obcymi ludzmi (przydzielonymi do mojej grupy, bo oczywiście liczy się tylko teamwork) kłócić się co, jak i w jakim języku napisać.